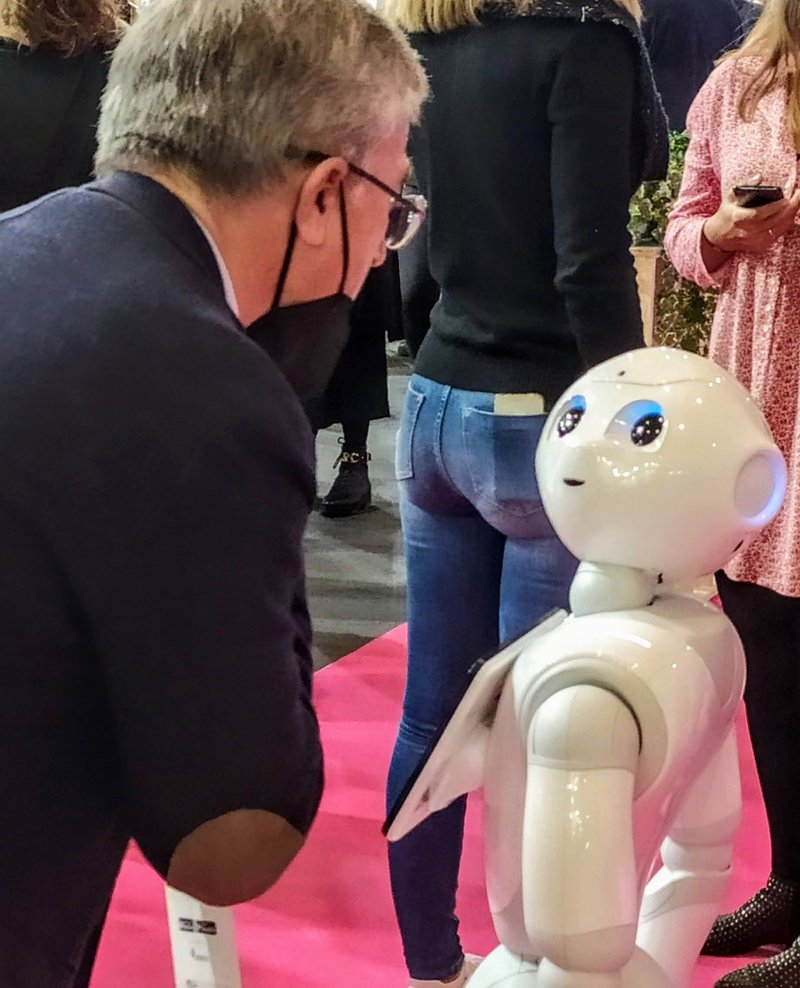

Els robots podran estimar

Literalment, això no serà possible. Els robots no podran mai estimar, però sí que seran capaços d’interpretar les emocions humanes, llegir els paràmetres que els faran detectar si la persona que tenen al davant està contenta, trista, té por o ànsia. No podran estimar, però sabran com expressar aquest sentiment. A hores d’ara, encara som lluny dels humanoides que actuaran emocionalment com a humans. Primer hauran d’aprendre a interpretar els signes que evidencien cada estat d’ànim i, molt després, se’ls indicarà com s’han d’expressar ells mateixos.

En tot cas, equips d’investigadors estan fent les primeres passes en la computació afectiva, l’àmbit tecnològic que s’endinsa en aquesta enrevessada xarxa que són les emocions i que té com a missió traduir l’afectivitat en algoritmes i ensinistrar els robots en la seva identificació.

El CIDAI (Centre of Innovation for Data Tech and Artificial Intelligence), d’Eurecat Centre Tecnològic de Catalunya, va organitzar una masterclass a finals de gener, impartida per Àgata Lapedriza, professora de la UOC, directora del grup de recerca Artificial Intelligence for Human Well-being a l’eHealth Research Center de la UOC, i investigadora afiliada al Massachusetts Institute of Technology (MIT) Medialab, al grup de recerca Afective Computing.

Lapedriza i l’equip amb què treballa estudia i desenvolupa sistemes i dispositius per reconèixer, interpretar i simular les emocions humanes. Explicava que avui dia ja hi ha dispositius capaços de processar alguns senyals visuals, de llenguatge o de veu en situacions molt concretes, però que el camí per fer és complex. “A la màquina li has de donar molts exemples perquè aprengui a desxifrar una emoció, perquè la identifiqui com a felicitat, tristor, sorpresa, perill, disgust o por, que són les bàsiques i més comunes, però n’hi ha moltes més”, deia Lapedriza.

D’altra banda, afegia, “també s’ha de tenir en compte que la mateixa expressió en diferents contextos pot tenir significats diferents”. Per tant, s’ha de farcir la màquina de milers d’imatges i ajudar-la a fer-ne correctament la interpretació.

A més dels senyals visuals, també se l’ha d’ensinistrar en el llenguatge natural, la veu, i els senyals fisiològics, perquè l’afectivitat humana utilitza tots aquests camps per mostrar-se. “Actualment, tenim més desenvolupats els models per a text i imatges, i ja s’han pogut fer proves amb robots i estudiants perquè també hem d’esbrinar quina és la percepció que té l’usuari d’aquesta interacció”, assenyalava Lapedriza.

Queden molts reptes per assolir, però la tecnologia ja està posant les bases per fer possible en un futur (llunyà) les interaccions socials dels robots amb les persones.